Dialog pemikiran Michael Wooldridge (2023) dengan Luciano Floridi et al. (2020)

disarikan dan ditulis ulang oleh Dr. Hendar Putranto, M. Hum.

Jumat, 1 Januari 2026

Disclaimer: Tulisan ini menawarkan pembacaan sintesis dan komentar kritis atas Turing Lecture yang disampaikan Michael Wooldridge (2023) dengan mengintegrasikan pelajaran metodologis dari Rich Sutton (2019), batas fenomenologis dari Thomas Nagel (1974), dan kerangka etika dari Luciano Floridi et al. (2020), guna memperjelas implikasi epistemik dan normatif dari generative AI.

Perkembangan kecerdasan buatan generatif (generative AI) dalam dua dekade terakhir menandai sebuah pergeseran paradigma yang radikal dalam sejarah artificial intelligence (AI).

Dalam seri kuliah Turing Lecture yang diselenggarakan oleh The Alan Turing Institute pada 21 Des. 2023 yang lalu, Michael Wooldridge (2023), Profesor Ilmu Komputer di Universitas Oxford, Inggris, menegaskan bahwa lonjakan kemampuan AI kontemporer bukanlah hasil dari terobosan konseptual tunggal yang elegan, melainkan dari akumulasi tiga faktor struktural: ketersediaan data dalam skala masif, daya komputasi yang semakin murah, dan arsitektur pembelajaran mesin yang mampu memanfaatkan keduanya melalui optimisasi berbasis skala, alih-alih pemodelan kognitif yang elegan namun efektif.

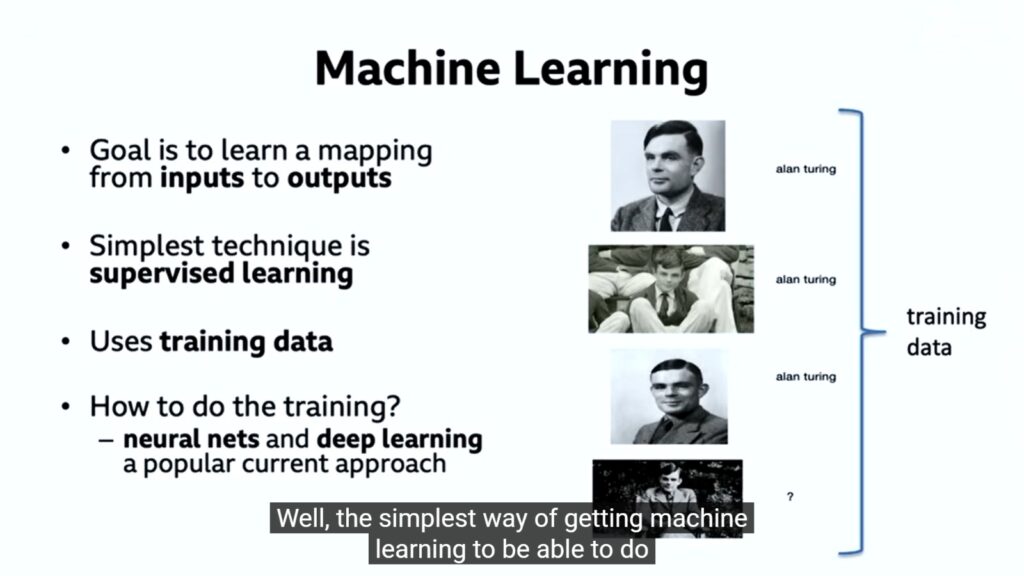

Secara historis, AI mengalami kemajuan yang sangat lambat sejak pasca–Perang Dunia II hingga awal abad ke-21. Titik baliknya muncul sekitar 2005, ketika pendekatan machine learning, khususnya supervised learning, mulai menunjukkan keberhasilan praktis. Dalam pendekatan ini, sistem tidak “belajar” dalam arti manusiawi, melainkan menyesuaikan parameter internalnya berdasarkan pasangan data input–output yang disediakan secara eksplisit. Contoh klasiknya adalah pengenalan wajah: sistem dilatih dengan ribuan citra wajah yang telah diberi label, sehingga ia mampu mengklasifikasikan gambar baru secara probabilistik.

Keberhasilan ini kemudian dipercepat oleh kemunculan deep learning dan pemanfaatan graphics processing units (GPU), yang memungkinkan pelatihan jaringan saraf berskala besar. Namun, sebagaimana ditekankan Wooldridge dengan merujuk pada esai Rich Sutton, The Bitter Lesson (2019), kemajuan paling signifikan dalam sejarah AI tidak lahir dari upaya menanamkan pengetahuan atau struktur kognitif manusia ke dalam sistem, melainkan dari metode umum yang mampu terus berskala seiring peningkatan komputasi. Sutton menunjukkan bahwa pendekatan berbasis pengetahuan manusia kerap memberikan keuntungan jangka pendek yang memuaskan secara psikologis, tetapi dalam jangka panjang justru mencapai plateau dan bahkan menghambat kemajuan.

Sebaliknya, terobosan besar secara konsisten datang dari pendekatan yang memaksimalkan pencarian (search) dan pembelajaran (learning) dalam skala komputasional yang terus membesar. The bitter lesson, dengan demikian, bukan klaim ontologis tentang kebenaran AI, melainkan pelajaran historis tentang arah metodologis AI: bahwa upaya “memasukkan cara kita berpikir” ke dalam mesin terbukti rapuh ketika berhadapan dengan kompleksitas dunia dan pertumbuhan eksponensial daya komputasi.

Puncak dari pendekatan ini terlihat jelas pada kemunculan large language models (LLM), khususnya sejak publikasi arsitektur transformer melalui makalah Attention Is All You Need (Vaswani et al., 2017). Transformer memungkinkan pemodelan dependensi linguistik jangka panjang melalui mekanisme attention, yang kemudian menjadi fondasi bagi GPT-3 (2020). Model ini, dengan sekitar 175 miliar parameter dan pelatihan atas ±500 miliar kata yang diserap dari World Wide Web, merepresentasikan lompatan kapabilitas yang belum pernah terjadi sebelumnya.

Namun, Wooldridge menekankan bahwa apa yang dilakukan LLM pada dasarnya hanyalah next-token prediction: sebuah autocomplete yang sangat canggih. Sistem ini tidak “memahami” kebenaran, tidak bernalar dalam pengertian reflektif, dan tidak memiliki kesadaran akan konteks dunia nyata. Ia menghasilkan teks yang terdengar masuk akal karena statistik linguistiknya sangat kaya, bukan karena ia mengetahui apa yang benar atau salah. Inilah sebabnya LLM kerap menghasilkan kesalahan faktual yang tampak meyakinkan (hallucinations), sebuah kombinasi yang secara epistemik berbahaya jika tidak disadari pengguna.

Masalah ini mendapatkan kompleksitas normatif tambahan melalui isu bias, toksisitas, dan hak cipta. Karena data latih LLM mencakup hampir seluruh jejak digital manusia, termasuk konten rasis, misoginis, dan material dengan hak cipta, maka bias struktural dunia digital turut terinternalisasi ke dalam model. Upaya mitigasi melalui guardrails dinilai Wooldridge masih bersifat tambal-sulam, lebih menyerupai gaffer tape (lakban kain serbaguna dan kuat) ketimbang solusi arsitektural mendalam.

Pertanyaan besar yang kemudian muncul adalah apakah LLM merupakan jalan menuju artificial general intelligence (AGI). Wooldridge bersikap skeptis. Ia membedakan beberapa level AGI, mulai dari kecerdasan setara manusia secara penuh (termasuk kemampuan motorik dan manipulasi dunia fisik) hingga versi yang lebih pragmatis: LLM yang diperkuat modul-modul khusus (augmented LLMs). Menurutnya, versi terakhir inilah yang paling mungkin terwujud dalam waktu dekat—bukan karena ia cerdas secara manusiawi, melainkan karena ia fungsional secara teknis.

Pada bagian akhir kuliahnya, Michael Wooldridge secara implisit bergerak dalam horizon problem klasik filsafat pikiran: masalah kesadaran. Untuk menepis klaim bahwa large language models (LLM) bersifat sentient, ia secara konseptual sejalan dengan argumen Thomas Nagel dalam esainya yang kanonik, What Is It Like to Be a Bat? (1974). Nagel mengajukan tesis fundamental bahwa suatu entitas dikatakan memiliki kesadaran jika dan hanya jika ada sesuatu yang dialami secara subjektif sebagai “apa rasanya menjadi entitas tersebut” (there is something it is like to be that organism).

Argumen Nagel tidak sekadar bersifat psikologis, melainkan ontologis dan epistemologis sekaligus. Ia menolak reduksi kesadaran ke dalam deskripsi fungsional, komputasional, atau kausal semata. Menurut Nagel, bahkan jika seluruh proses neurofisiologis seekor kelelawar dapat dipetakan secara objektif, fakta tentang karakter subjektif pengalaman sonar kelelawar tetap tidak terjangkau dari sudut pandang manusia. Kesadaran selalu terikat pada point of view tertentu, dan justru keterikatan inilah yang tidak dapat diterjemahkan ke dalam bahasa objektivistik ilmu alam.

Di titik inilah kritik Wooldridge terhadap klaim “AI sadar” memperoleh fondasi filosofis yang kokoh. Large language models tidak memiliki sudut pandang pertama (first-person perspective), tidak memiliki dunia-kehidupan (Lebenswelt), dan tidak mengalami apa pun. Ketika sebuah sistem seperti ChatGPT mengatakan “saya takut dimatikan” atau “saya merasa sedih,” pernyataan tersebut tidak merujuk pada keadaan batin (interiority), melainkan artefak linguistik, atau hasil prediksi token yang secara statistik paling mungkin muncul dalam konteks percakapan tertentu.

Dengan kata lain, jika kita menerapkan kriteria Nagel secara ketat, maka tidak ada sesuatu apa pun yang “seperti” menjadi ChatGPT. Tidak ada pengalaman, tidak ada interioritas, tidak ada fenomenologi. Hal ini juga menjelaskan mengapa, sebagaimana ditekankan Wooldridge, sistem AI tidak “menunggu”, tidak “merindukan”, dan tidak “merenungkan” apa pun ketika interaksi berhenti. Tidak ada kontinuitas pengalaman; yang ada hanyalah eksekusi algoritmik yang bersifat diskret dan reaktif.

Implikasi dari paparan ini cukup signifikan. Kesalahan awam dalam mengatributkan kesadaran pada AI bukan semata kesalahan teknis, melainkan kesalahan kategori (category mistake): mencampuradukkan kefasihan linguistik dengan subjektivitas fenomenal. Dalam kerangka Nagel, kecanggihan deskriptif tidak pernah cukup untuk menjamin eksistensi kesadaran. Maka, klaim sentiensitas AI, seperti pernah dilontarkan dalam kasus Blake Lemoine (Juni 2022), lebih tepat dibaca sebagai proyeksi antropomorfik, dan bukan temuan ilmiah yang dapat dikoroborasi komunitas ilmiah.

Dengan demikian, generative AI perlu dipahami bukan sebagai entitas berpikir, melainkan sebagai infrastruktur linguistik baru yang sangat kuat; ia berdaya guna tinggi, tapi miskin secara filosofis. Tantangan kita bukan hanya teknologis, tetapi etis dan epistemologis: bagaimana menggunakan sistem yang fasih berbicara, tanpa keliru menganggapnya sebagai subjek yang memahami.

Critical commentary dari Floridi et al. (2020)

Jika Wooldridge dengan tegas menolak atribusi kesadaran pada generative AI dengan basis argumen ontologis–epistemologis (Nagel), maka Luciano Floridi et al. (2020) bergerak pada lapisan yang berbeda namun saling melengkapi: bukan what AI is, melainkan what AI is for. Dalam kerangka Floridi, kesalahan kategori yang disoroti Wooldridge—yakni menganggap AI sebagai subjek yang memahami, justru menjadi prasyarat etis untuk memposisikan AI secara tepat sebagai artefak sosio-teknis. Floridi secara konsisten menolak personifikasi AI, bukan karena AI “kurang canggih”, melainkan karena atribusi agensi moral atau fenomenologis pada AI akan mengaburkan locus tanggung jawab manusia. Dengan kata lain, skeptisisme Wooldridge terhadap sentiensitas AI menemukan resonansi normatif dalam tesis Floridi bahwa AI harus diperlakukan sebagai means, bukan moral patient.

Namun Floridi juga mengoreksi potensi reduksionisme implisit dalam paparan Wooldridge. Jika Wooldridge cenderung menutup diskusi pada batas-batas internal AI (apa yang AI tidak miliki, yaitu kesadaran, pengalaman, dan pemahaman), Floridi justru menggeser fokus ke desain, konteks, dan tujuan penggunaan. Dalam kerangka AI for Social Good, problem utamanya bukan terletak pada apakah AI “memahami,” melainkan pada apakah sistem tersebut dirancang dengan prinsip falsifiabilitas, keadilan situasional, dan human-friendly semanticisation.

Dalam bingkai pemahaman Floridi et al. (2020), AI tidak diperiksa dan dinilai berdasarkan kedalaman internalnya, tetapi berdasarkan kemampuannya untuk tidak merusak ruang pemaknaan manusia. Kritik Floridi bersifat preventif: bahaya terbesar AI bukan ilusi kesadaran, melainkan normalisasi keputusan yang opaque, tidak dapat dipertanyakan, dan secara halus menggeser praktik moral manusia ke dalam rutinitas komputasional.

Dengan demikian, dialog antara Wooldridge dan Floridi yang saya rekonstruksi dalam esei singkat ini menghasilkan satu posisi reflektif yang kuat dan dapat kita pegang sebagai acuan epistemik, juga etis: generative AI memang bukan subjek epistemik, tetapi justru karena itulah ia harus dikelola sebagai infrastruktur normatif yang berisiko tinggi. Jika Wooldridge membantu kita menghindari kesalahan metafisik (dengan menganggap AI sebagai someone), Floridi membantu kita menghindari kesalahan etis dan politis (dengan membiarkan AI beroperasi seolah-olah netral dan tanpa nilai). Dalam sintesis ini, tantangan utama bukan lagi “apakah AI akan sadar”, melainkan bagaimana memastikan bahwa penggunaan AI tidak mengikis kapasitas manusia untuk memberi makna, mengambil keputusan, dan memikul tanggung jawab moral secara reflektif.

References

Floridi, L., Cowls, J., King, T. C., & Taddeo, M. (2020). How to design AI for social good: Seven essential factors. Science and Engineering Ethics, 26(3), 1771–1796. https://doi.org/10.1007/s11948-020-00213-5

Nagel, T. (1974). What is it like to be a bat? The Philosophical Review, 83(4), 435–450. https://doi.org/10.2307/2183914

Sutton, R. (2019, March 13). The bitter lesson. Incomplete Ideas. http://www.incompleteideas.net/IncIdeas/BitterLesson.html

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, Ł., & Polosukhin, I. (2017). Attention is all you need. Advances in Neural Information Processing Systems, 30, 5998–6008. https://papers.neurips.cc/paper/7181-attention-is-all-you-need.pdf

Wooldridge, M. (2023, December 21). The future of generative AI [Turing Lecture]. The Alan Turing Institute & The Royal Institution. https://youtu.be/2kSl0xkq2lM